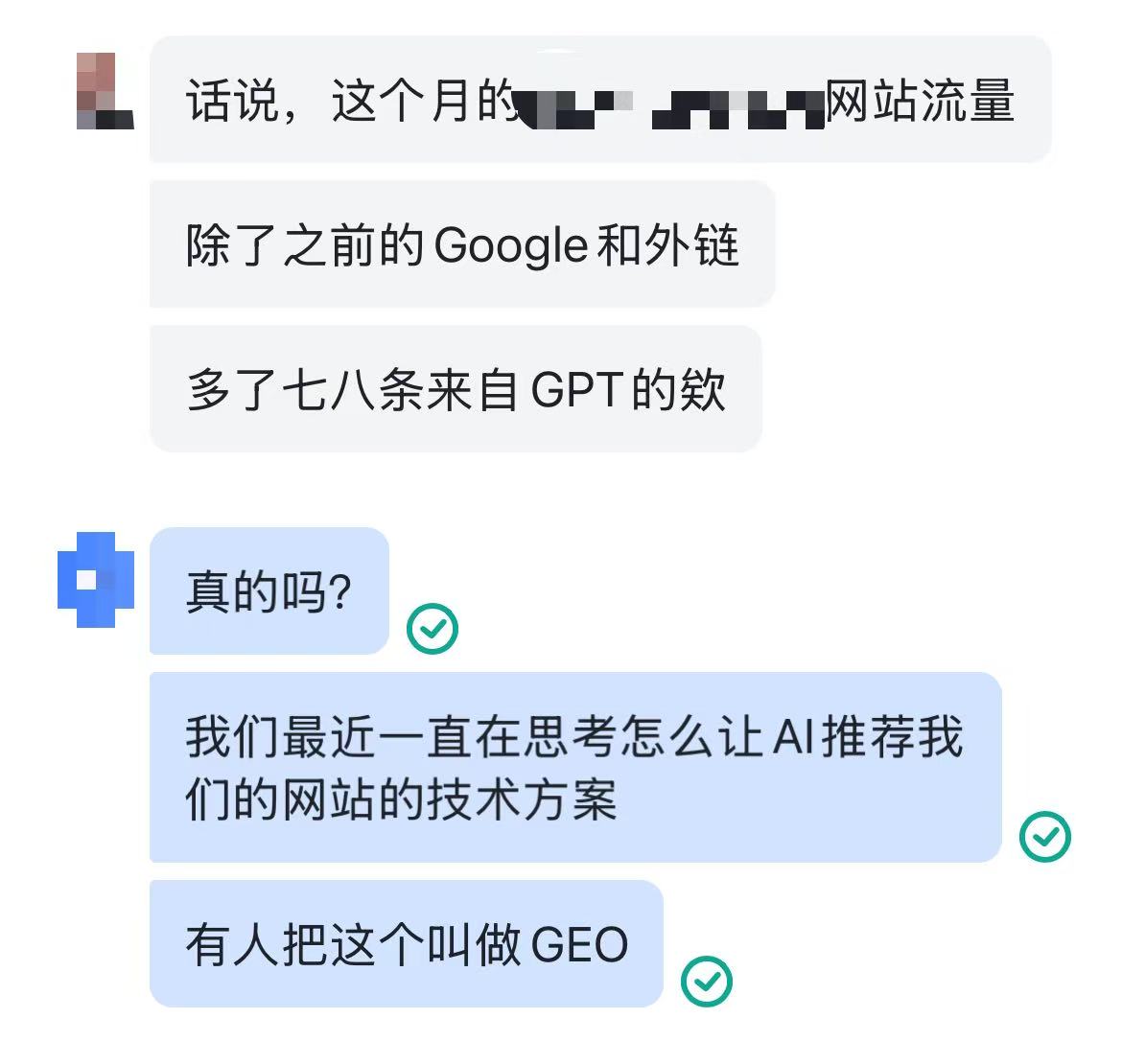

话说我们有个给某B2B外贸公司做的独立站,上个月底,和我们对接的运营小哥很惊讶地和我们说:

“除了传统的Google和外链来源,还多了来自GPT的流量。”

除了SEO,还有AI LLM EO

在这个向外卷的时代,我们和我们的客户都在思考如何让更多潜在客户看到自己。

而AI大模型,已经成了大家找信息、要答案、跟世界互动的新方式:

- 很多人遇事不决,先打开Deepseek或者豆包或者GPT先问一下)。

- 大家不光在搜索框里敲字找信息了,他们开始直接问AI,让AI来给他们总结、分析,然后直接给出答案或者方案。

我们之前意识到,光把网站做得功能齐全,做好SEO(包括琢磨算法和关键词、折腾网站的速度、可读性、robots.txt、sitemap.xml等等)可不够了。

还需要让AI大模型看到,索引,并且优化得能让大模型推荐。

而这个事情,也有很多比我们更聪明的人一直在探索。

从大模型对更全、更准、更有效的信息角度出发,Jeremy Howard提出的 llms.txt 方案,是供给端的一个可行性很高的方案。

关于 Jeremy Howard 关于标准化使用 llms.txt 的提案原文,可以点击此处查看原文翻译版本

最重要的是,目前Anthropic (Claude)和Perplexity这些大模型或拥有联网检索能力的大模型应用,已经逐步开始支持 llms.txt 。

经过内部探讨,我们拍板决定:从今往后,我们团队做的所有网站,都得把 llms.txt 这玩意儿给加上,同时对旧站的维护过程中,也加入 llms.txt (不额外收费)!

从“被动挨打”到“主动出击”

我们做的网站(可能是一个外贸独立站,可能是一个公司官网,可能是一个个人博客,可能是一个卖线上服务的SaaS等等)不光要让搜索引擎喜欢,更要让AI喜欢(或者说让AI对其评价更好)。

传统的网站,对AI来说,会包括一堆“噪音”和“垃圾信息”——各种酷炫的动画、各种格式标记、各种开发框架自带的技术信息、还有关联度可能很低的广告(但会误导大模型)。

AI得吭哧吭哧地花大力气去分析、筛选,搞不好还会“脑补”出一些不靠谱的东西,给出不准确的答案。 llms.txt 就是一个能让AI更高效、更准确地理解我们客户网站的“精髓”的可选方案。

不只是个技术文件,更是网站和AI大模型之间建立“官方热线”的关键!它让我们从以前“被动地等着AI来读取/分析/理解”,变成了“主动地去告诉AI我有啥”,手把手地引导它精准地理解和展示客户的品牌信息。

和robots.txt以及sitemap.xml有咩不同?

| 文件名称 | 核心目的 | 主要受众 |

|---|---|---|

robots.txt | 管理爬虫行为: 告诉搜索引擎爬虫(如Googlebot、Baiduspider)哪些页面可以抓取,哪些页面禁止抓取,以避免服务器过载或保护隐私内容。 | 传统搜索引擎爬虫(Web Crawlers) |

sitemap.xml | 提供网站地图: 列出网站所有可供搜索引擎索引的页面URL,帮助搜索引擎更全面地发现和抓取网站内容,尤其对新站或内容更新频繁的网站有益。 | 传统搜索引擎爬虫(Web Crawlers) |

llms.txt | 优化AI理解: 为大型语言模型(LLMs)提供网站最核心、最精华、最纯净的内容指引,帮助AI更高效、准确地理解网站信息,减少“幻觉”和误报。 | 大型语言模型(LLMs)及其驱动的应用(如AI聊天机器人、AI搜索引擎) |

robots.txt、sitemap.xml 和 llms.txt 都是网站与外部“机器人”世界沟通的重要桥梁。robots.txt 设定了“边界”,sitemap.xml 提供了“地图”,而 llms.txt 则提供了“精华导览”。

合理配置这“三剑客”,将是我们给客户做开发时,涉及对外公开服务的网站的默认项。

目的在于共同确保了:网站内容能够被搜索引擎和AI大模型高效、准确地发现、索引和理解,从而在不同的信息消费场景中发挥最大价值。

我们是怎么把llms.txt“塞”进开发流程的?

把 llms.txt 不是随便生成个文件那么简单。这背后,需要双方的持续配合,我们得深入了解客户的业务,还得重新琢磨内容的呈现方式。我们通常会这么干:

-

内容“大扫除”和“战略部署”: 项目刚开始,我们就会跟客户坐下来好好聊聊,把网站里那些核心内容、关键产品/服务信息、品牌故事、技术文档什么的,都捋一遍。我们会引导客户想想,哪些信息是他们最希望AI能准确传达给用户的。这可不光是技术活儿,更是帮客户把品牌的核心价值再“提炼”一遍。

-

高质量Markdown内容“生产线”:

llms.txt的核心就是提供高质量的Markdown版本内容。我们会帮客户把这些核心信息,转化成简洁、清晰、没废话的Markdown格式。比如产品介绍、API文档、常见问题解答、公司简介等等。我们得确保这些Markdown内容既能让AI高效地“啃”,也能让人类读起来舒服。 -

llms.txt文件“精雕细琢”: 搞定了内容,我们就会严格按照

llms.txt的规矩,把文件结构搭起来。我们会巧妙地利用H1、H2标题、引用块和链接列表,确保AI能一眼就找到最重要的信息。至于那些虽然有点用但不是特别重要的内容,我们会把它放到“Optional”部分,这样AI在需要“速读”的时候就可以跳过。 -

“售后服务”和“持续升级”:

llms.txt可不是一劳永逸的。随着客户业务发展,网站内容更新,llms.txt也得跟着“升级”。我们会给客户详细的维护建议,还会提供一些工具支持,确保llms.txt永远都是最新、最棒的。

举个例子,一家SaaS公司的核心产品除了面向普通用户的网页界面,还有面向技术用户的复杂API服务。精心配置的

举个例子,一家SaaS公司的核心产品除了面向普通用户的网页界面,还有面向技术用户的复杂API服务。精心配置的 llms.txt,提供了详细的API文档Markdown版本。理想的结果是开发者可以直接通过AI编程助手,根据 llms.txt 提供的准确信息,快速找到解决方案。这不光让用户用得爽,也大大减轻了客服的负担,一举两得。

下篇文章,我们会给分享我们关于 llms.txt的技术笔记,包括如何在wordpress/react/vue等各种技术框架里面实现静态/动态 llms.txt,以及持续分享我们对 llms.txt的技术解读,以及其他有意思的网站的 llms.txt!

关于 Jeremy Howard 关于标准化使用 llms.txt 的提案原文,可以点击此处查看原文翻译版本

关于我们: 我们是一家专业的技术服务公司。我们提供小而美但集中于单点问题快速解决的工具/系统,覆盖方案咨询、软件开发、系统集成和人工智能解决方案,为客户做官网、landing page、独立站是外延服务的重要部分。具体包括:

关于我们:

- IT服务层面:①定制开发(针对业务痛点定制单点高可用工具或系统);②系统集成连接(无缝连接新旧系统与内部外部SaaS工具,实现跨平台业务流自动化);③信息化数字化咨询(基于数字化提效行业实践,以及技术方案落地实施经验积累,提供针对性的单点咨询服务)。

- AI服务层面:①AI工作流自动化(将AI决策嵌入业务流,如询盘→CRM自动化,压缩端到端处理时间及人力成本60%以上);②多模态AI洞察(AI+文本、图像、语音、视频,从文件到数据再到信息,发现隐藏业务价值);③AI知识库驱动内容创作生成(基于行业知识库与业务Insight,生成社交媒体Post/营销文案/产品文档……)。 欢迎通过联系我们,沟通您的定制需求,获取您的专属方案。

Cover Image by wordgardener from Pixabay.